С момента основания в 1993 году NVIDIA последовательно меняла представления о том, на что способна видеокарта. Сегодня ее продукция охватывает широкий спектр решений — от бюджетных моделей до передовых GPU с поддержкой трассировки лучей и нейросетевых технологий.

В этой статье мы подробно рассмотрим все видеокарты NVIDIA по порядку, начиная с первых, почти забытых, но исторически значимых моделей, и заканчивая флагманскими решениями на архитектуре Ada Lovelace. Вы узнаете, как эволюционировали графические процессоры NVIDIA. Какие архитектуры стали поворотными. Какие видеокарты вошли в историю, как легендарные. И как менялись приоритеты компании: от повышения производительности до энергоэффективности, от DirectX 6 до поддержки DLSS и трассировки лучей в реальном времени.

Все серии видеокарт NVIDIA: история и эволюция

Графические ускорители NVIDIA за три десятилетия прошли путь от простых 2D-чипов до высокопроизводительных решений, способных обрабатывать сложнейшие визуальные сцены в реальном времени. Эволюция этих устройств напрямую повлияла не только на развитие игровой индустрии, но и на такие ключевые сферы, как 3D-моделирование, научные вычисления, машинное обучение и нейросети.

Компания NVIDIA с самого начала делала ставку на разработку специализированных графических процессоров (GPU), в отличие от других производителей, стремившихся комбинировать графику и вычисления в одном устройстве. Именно этот фокус стал залогом технологического лидерства компании.

С момента выхода первой серии видеокарт RIVA до современных флагманов линейки GeForce RTX, включая RTX 4090 и RTX 4080, NVIDIA последовательно внедряла архитектурные новшества, расширяла вычислительные возможности GPU и активно формировала новые стандарты графики.

Мы предлагаем детально проследить путь NVIDIA, от первых экспериментов до доминирования на рынке видеокарт. Рассмотрим ключевые поколения, архитектурные вехи, рыночные повороты и революционные технологии, сделавшие видеокарты NVIDIA синонимом производительности и инноваций.

Ранние годы и серия RIVA

До того, как видеокарты NVIDIA стали ассоциироваться с флагманскими решениями вроде GeForce RTX 4090 и технологий трассировки лучей, компания прошла непростой путь становления. В начале 1990-х графический рынок находился в зачаточном состоянии. Большинство компьютеров ограничивались базовыми 2D-возможностями, а специализированные 3D-ускорители только начали формироваться, как отдельный сегмент.

Первым графическим продуктом NVIDIA стала модель NV1, выпущенная в 1995 году. Это был экспериментальный гибрид, совместивший графические, аудио- и игровые функции. Несмотря на новаторство, NV1 не стала коммерчески успешной. Ее нестандартный подход к 3D-графике и ориентация на интерфейс Quadratic Texture Mapping (вместо перспективных OpenGL и Direct3D) оттолкнули разработчиков. Однако этот неудачный старт дал NVIDIA ценный опыт, который был реализован в следующем поколении.

Настоящий прорыв произошел в 1997 году с выпуском серии RIVA (Real-time Interactive Video and Animation). Первая карта этой линейки RIVA 128 (NV3) стала полноценным 3D-ускорителем с поддержкой Direct3D и OpenGL. Впервые NVIDIA предложила универсальное решение для массового рынка, обеспечивающее высокую производительность по сравнению с конкурентами вроде 3dfx Voodoo и ATI Rage.

RIVA 128 получила 4 МБ памяти SGRAM, 128-битную шину и поддержку разрешения до 1600х1200 пикселей, что по тем временам было впечатляющим показателем. Она могла обрабатывать до 1,6 млн треугольников в секунду — результат, позволивший ей занять уверенные позиции как в игровых системах, так и в профессиональных средах.

В 1998 году NVIDIA представила RIVA TNT (NV4) — видеокарту, закрепившую успех компании. В отличие от предшественников, TNT (Twins 'N' Texels) обеспечивала двойной пиксельный конвейер и аппаратную поддержку 32-битного цвета, что было крайне важно для растущих требований 3D-графики. Улучшенная фильтрация текстур, а также поддержка более высоких частот сделали ее достойным ответом на конкуренцию с Voodoo2 и Matrox G200.

Появление RIVA TNT2 в 1999 году стало последним этапом перед запуском культовой серии GeForce. TNT2 отличалась более высокой частотой ядра (до 150 МГц), поддержкой до 32 МБ видеопамяти и расширенными возможностями рендеринга. Эта модель активно использовалась в игровых ПК и OEM-сегменте, благодаря чему NVIDIA значительно расширила свою долю на рынке.

Появление и развитие серии NVIDIA GeForce (все модели, знакомые многим)

В том же 1999 году NVIDIA совершила качественный скачок, представив первую видеокарту GeForce 256. Эта модель стала началом легендарной серии, определившей будущее рынка графических ускорителей. Именно все видеокарты GeForce положили начало термину GPU (Graphics Processing Unit), подчеркивая, что — это не просто дополнение к системе, а полноценный процессор для графических вычислений.

Главной инновацией GeForce 256 стало аппаратное трансформирование и освещение (T&L), ранее обрабатывавшееся исключительно центральным процессором. Это разгрузило CPU и обеспечило значительный прирост производительности в 3D-играх. Также карта имела поддержку AGP 4x и 32 МБ DDR-памяти, что делало ее одним из самых продвинутых решений на рынке.

Поколение видеокарт GeForce 2 (2000 г.) развило успех, предложив увеличенную тактовую частоту, улучшенную работу с текстурами и поддержку новых графических технологий. Эти видеокарты активно использовались как в домашних ПК, так и в рабочих станциях.

В 2001 году GeForce 3 принес поддержку DirectX 8.0 и программируемых шейдеров, что открыло путь к созданию более реалистичной графики в играх. А GeForce 4, появившаяся год спустя, отличалась высокой частотой работы ядра и улучшенным рендерингом нескольких текстур.

Ранние серии видеокарт GeForce стали стандартом качества и производительности для своей эпохи. NVIDIA закрепила статус новатора и лидера, а сама линейка видеокарт GeForce превратилась в узнаваемый бренд, который и сегодня ассоциируется с мощной игровой графикой.

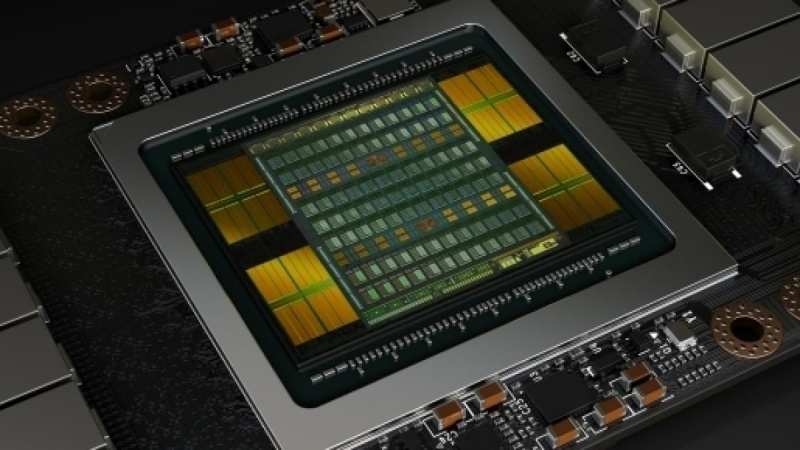

Переход к архитектурам CUDA и Fermi

К середине 2000-х стало очевидно, что потенциал видеокарт выходит далеко за рамки рендеринга графики. NVIDIA сделала стратегически важный шаг, представив в 2006 году архитектуру CUDA (Compute Unified Device Architecture) — платформу для параллельных вычислений на базе GPU. Благодаря CUDA, видеокарты стали использоваться не только в играх, но и в научных, инженерных и промышленных задачах: от моделирования молекулярной динамики до обработки больших данных и машинного обучения.

Появление CUDA открыло путь к GPGPU (General-Purpose computing on Graphics Processing Units) — универсальным вычислениям на видеокартах. Программисты получили возможность писать коды на C/C++ и запускать их прямо на GPU, что значительно ускоряло выполнение ресурсоемких задач. Это сделало видеокарты NVIDIA популярными среди разработчиков и исследователей.

Кульминацией этого подхода стала архитектура Fermi, представленная в 2010 году вместе с видеокартами серии GeForce GTX 400. Fermi объединила игровую и вычислительную мощности, став первой архитектурой NVIDIA с полной поддержкой DirectX 11, OpenCL и технологии ECC-памяти (коррекция ошибок), что особенно важно для научных вычислений и рабочих станций.

Все модели GTX содержат ключевые особенности Fermi:

- до 512 CUDA-ядер, что дало значительный прирост производительности;

- улучшенная поддержка многозадачности и параллельных потоков;

- повышенная точность вычислений и надежность работы.

Fermi была не просто техническим прорывом. Она обозначила переход видеокарт NVIDIA в эру универсальности. Карты на этой архитектуре стали использоваться в суперкомпьютерах и дата-центрах, а рынок видеокарт для игр и работы стал пересекаться, как никогда ранее.

С этого момента поколение NVIDIA закрепило свое лидерство не только среди геймеров, но и в сфере высокопроизводительных вычислений, открыв новую эру GPU-ускоренных технологий.

Улучшенный модельный ряд NVIDIA: эра Maxwell и Pascal

После амбициозной, но энергоемкой Fermi и сбалансированной Kepler, компания NVIDIA сделала акцент на энергоэффективности и оптимизации архитектуры. Так началась эпоха Maxwell — архитектуры, ставшей символом видеокарт с отличным соотношением производительности и энергопотребления. Первые модели на ее базе появились в 2014 году: GeForce GTX 750 и GTX 750 Ti. Они стали настоящим открытием в сегменте доступных видеокарт, обеспечив высокую производительность при минимальном энергопотреблении (всего 60 Вт), что позволило использовать их даже без дополнительного питания.

Максимального размаха Maxwell достигла с выходом серии видеокарт NVIDIA GTX 900. Модели GTX 970 и GTX 980 быстро завоевали популярность среди геймеров, предложив высокую производительность в разрешении Full HD и WQHD. Особенно выделялась GTX 980 Ti, которая на момент выхода стала одной из лучших видеокарт для игр, конкурируя с топовыми решениями AMD. Maxwell также принес улучшенную работу с памятью, поддержку новых API и технологии DSR (Dynamic Super Resolution), позволяющей рендерить изображение в 4K и масштабировать его для Full HD-мониторов с повышенной четкостью.

Следующим этапом стала архитектура Pascal, представленная в 2016 году. С ней поколение видеокарт NVIDIA перешло на 16-нм техпроцесс, что позволило добиться огромного прироста производительности и эффективности. На базе Pascal были выпущены легендарные модели:

- GeForce GTX 1060, до сих пор используемая миллионами пользователей;

- GTX 1070 и GTX 1080, обеспечившие плавный гейминг в 2K и 4K;

- GTX 1080 Ti — один из самых успешных флагманов в истории NVIDIA.

Pascal принес поддержку технологии Ansel, Simultaneous Multi-Projection, а также более быструю видеопамять GDDR5X. Кроме того, Pascal стал фундаментом для ноутбучных решений. Благодаря снижению энергопотребления, многие модели стали доступными в мобильном сегменте без серьезной потери производительности.

Поколение карт NVIDIA Pascal и Maxwell пользовались огромным спросом и в профессиональной среде, особенно в сегменте видеокарт для монтажа и 3D-визуализации. Энергоэффективность, стабильность и производительность сделали их актуальными на многие годы вперед. Даже сейчас на рынке можно встретить GTX 1060, GTX 1050 и другие модели в сборках начального и среднего уровня.

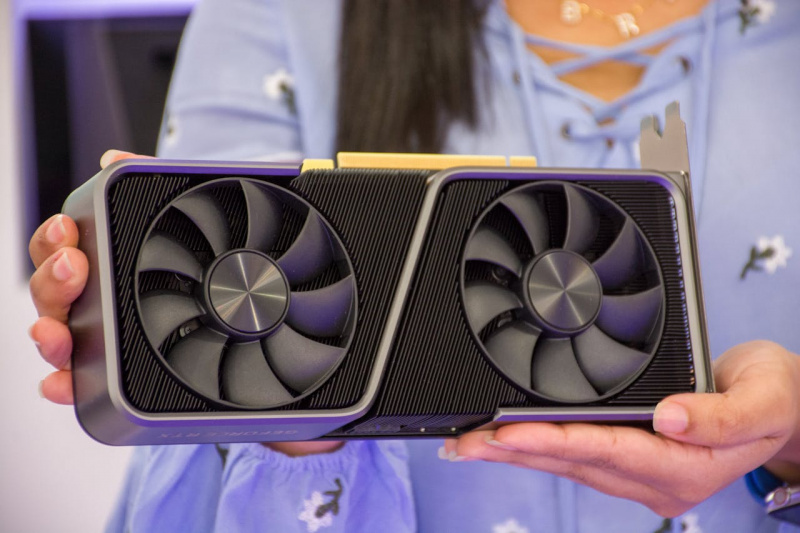

Серия RTX и технологии трассировки лучей

В 2018 году NVIDIA представила революционную линейку видеокарт GeForce RTX 20-й серии, которая ознаменовала переход к новой эре графики. Эти все видеокарты NVIDIA стали первыми массовыми GPU, поддерживающими трассировку лучей в реальном времени (Ray Tracing). Эта технология ранее была доступна только в киноиндустрии и рендер-фермах. С выходом RTX 2080 и RTX 2080 Ti игровая графика сделала огромный шаг вперед. Освещение, тени и отражения стали физически достоверными, создавая более реалистичную визуальную картину.

Ray Tracing реализуется за счет специальных RT-ядер, появившихся в архитектуре Turing. Поначалу новая технология вызывала скепсис из-за высокой стоимости и падения FPS при ее активации. Однако именно тогда NVIDIA представила и DLSS (Deep Learning Super Sampling) — интеллектуальное масштабирование изображения с помощью нейросетей, не только нивелирующее потери производительности, но и позволяющее повысить четкость картинки.

DLSS быстро эволюционировал от первой версии с ограниченным применением к DLSS 2.0 и 3.0, где появились временное сглаживание, генерация кадров и ощутимый прирост FPS даже в самых тяжелых сценах. Эта технология стала настоящим прорывом и весомым аргументом в пользу выбора видеокарт NVIDIA для игр и работы с графикой.

Среди моделей, задавших тон новому поколению:

- RTX 2060 — самый доступный вход в мир трассировки лучей;

- RTX 2070 — оптимальный вариант для игр в 1440p;

- RTX 2080 Super — мощное решение для 4K-гейминга.

Серия RTX также определила стандарт для будущих поколений. Отныне трассировка лучей и ИИ-ускорение стали обязательными компонентами современных видеокарт для игр, рендеринга и видеомонтажа. Актуальные приложения и игры, поддерживающие Ray Tracing и DLSS, постоянно пополняются, раскрывая потенциал этих технологий на максимум.

Современность: вся линейка видеокарт NVIDIA нового поколения

После успеха Turing NVIDIA сделала мощный технологический рывок, представив архитектуру Ampere, положившую начало серии RTX 30. Выпущенные в 2020 году видеокарты этой линейки, включая RTX 3060, RTX 3070, RTX 3080 и флагманскую RTX 3090, задали новый стандарт производительности и энергоэффективности. Архитектура Ampere получила усовершенствованные RT- и Tensor-ядра второго поколения, а также ускорители FP32. Это позволило достичь до двукратного прироста производительности по сравнению с Turing.

Ampere была тепло встречена рынком и быстро стала основой для сборок геймеров, создателей контента и специалистов в области ИИ. Карты этой серии поддерживают DLSS 2.0, что делает их актуальными даже спустя несколько лет после релиза.

В 2022 году на смену Ampere пришла архитектура Ada Lovelace, положившая начало серии RTX 40. Линейка видеокарт NVIDIA, включая RTX 4060 Ti, RTX 4070 Ti и топовую RTX 4090, представляет собой новый уровень в области визуальных вычислений. В Ada Lovelace NVIDIA внедрила DLSS 3 с генерацией кадров, что позволило значительно повысить плавность картинки даже в условиях сложных сцен.

Серия видеокарт NVIDIA с архитектурой Ada также принесла:

- поддержку AV1-кодека;

- улучшенные RT-ядра третьего поколения;

- более высокую энергоэффективность при сохранении экстремальной мощности.

RTX 4090 стала эталоном графической производительности и ориентиром для будущих релизов. Она активно используется не только в гейминге, но и в 3D-моделировании, инженерных задачах и ИИ-обработке.

Архитектура Blackwell, выпущенная в 2024 году, легла в основу серии GeForce RTX 50. Линейка видеокарт NVIDIA (условно обозначаемая, как RTX 5090, 5080 и младшие) — это очередной скачок в производительности, энергоэффективности и скорости ИИ-обработки. Новинки получили увеличенные кэш-памяти, еще более совершенные Tensor-ядра и улучшенную поддержку DLSS нового поколения.

Несмотря на это RTX 4070, RTX 4060 и RTX 4080 остаются популярными решениями для требовательных игр, стриминга и рабочих задач, а магазин Moon предлагает широкий выбор моделей на любой бюджет.

Список всех видеокарт NVIDIA, пользовавшихся особой популярностью (таблица поколений)

| Виды видеокарт NVIDIA | Архитектура | Год выпуска | Ключевые модели | Особенности |

| RIVA | NV1–TNT2 | 1995–1999 | RIVA 128, RIVA TNT, RIVA TNT2 | Первые графические ускорители NVIDIA, поддержка 2D/3D, прорыв на массовый рынок |

| GeForce 256–FX | Celsius, Lightspeed | 1999–2003 | GeForce 256, GeForce2 GTS, GeForce3, GeForce4 Ti, GeForce FX 5800 | Введение T&L-движка, поддержка DirectX 8, начало бренда GeForce |

| GeForce 6–9 Series | Curie | 2004–2008 | GeForce 6600 GT, 7600 GT, 8800 GT, 9800 GTX | Поддержка Shader Model 3.0, архитектура SLI, DirectX 9.0c |

| GeForce 100–300 | Tesla | 2008–2009 | GTS 250, GTX 260, GTX 285 | Переходный этап, оптимизация архитектуры G80/G92 |

| GeForce 400–500 | Fermi | 2010–2011 | GTX 460, GTX 480, GTX 580 | Введение CUDA в массовый сегмент, DirectCompute, улучшенная производительность FP32 |

| GeForce 600–700 | Kepler | 2012–2013 | GTX 660, GTX 670, GTX 760, GTX 780 Ti | Фокус на энергоэффективности, GPU Boost, поддержка PCIe 3.0 |

| GeForce 900 | Maxwell | 2014–2015 | GTX 960, GTX 970, GTX 980 Ti | Снижение энергопотребления, улучшенная производительность на ватт, поддержка HDMI 2.0 |

| GeForce 10 | Pascal | 2016–2017 | GTX 1050, GTX 1060, GTX 1070, GTX 1080 Ti | Поддержка DirectX 12, VR Ready, GDDR5X, резкий рост производительности |

| GeForce 16 | Turing (без RT) | 2019 | GTX 1650, GTX 1650 D6, GTX 1660 Ti | Бюджетные модели без RT-ядер, высокая производительность в Full HD |

| GeForce 20 | Turing | 2018–2019 | RTX 2060, RTX 2070, RTX 2080 Super | Первые RT- и Tensor-ядра, поддержка Ray Tracing и DLSS 1.0 |

| GeForce 30 | Ampere | 2020–2022 | RTX 3050, RTX 3060 Ti, RTX 3070 Ti, RTX 3080 | Увеличенная плотность CUDA-ядер, улучшенный DLSS 2.0, Ray Tracing 2-го поколения |

| GeForce 40 | Ada Lovelace | 2022–2024 | RTX 4060, RTX 4070, RTX 4080, RTX 4090 | DLSS 3, генерация кадров, RT-ядра третьего поколения, улучшенный AV1-кодек |

| GeForce 50 | Blackwell | 2025 | RTX 5090, RTX 5080 | Увеличенный кэш, новые Tensor-ядра, DLSS нового поколения, AI-оптимизации |

Заключение

История моделей видеокарт NVIDIA — это путь от первых графических ускорителей серии RIVA до современных мощнейших решений серии RTX 50. На каждом этапе развития компания демонстрировала инновационный подход: от запуска революционной серии GeForce, внедрения вычислительной архитектуры CUDA и мощной платформы Fermi, до эпохи Maxwell и Pascal с улучшенной энергоэффективностью и производительностью. Появление RTX с технологией трассировки лучей и развитием DLSS существенно подняло качество графики, задав новый стандарт визуальных эффектов. Современные архитектуры Ampere и Ada Lovelace продолжают расширять возможности GPU, предлагая высокий уровень вычислительной мощности для игр, профессиональных задач и искусственного интеллекта.

NVIDIA сыграла ключевую роль в формировании современного графического ландшафта, задавая векторы развития индустрии и влияя на весь рынок видеокарт. Благодаря постоянным инновациям и внедрению новых технологий, видеокарты NVIDIA остаются эталоном качества и производительности, что подтверждается широким выбором моделей на moon.kz. Их решения востребованы как среди геймеров, так и в профессиональных сферах, делая компанию неоспоримым лидером в мире графических процессоров.

Список использованных источников

- Wikipedia Список графических процессоров Nvidia

- Tom’s Hardware Nvidia Blackwell and GeForce RTX 50-Series GPUs: Specifications, release dates, pricing, and everything we know (updated) by Jarred Walton, January 17, 2025